En 1872, 13 años después de la aparición de su revolucionario El origen de las especies, Charles Darwin publicó otro libro. Fue un éxito de ventas sensacional, pese a que ahora pocos lo recuerden: en solo cuatro meses La expresión de las emociones en el hombre y en los animales vendió 9000 ejemplares, todo un best seller para su época.

A Darwin le encantaba observar a sus 10 hijos. Podía pasar horas analizando las expresiones que adoptaban sus rostros apenas nacían. Aquellas morisquetas despertaban su curiosidad, tanto que fueron el puntapié inicial que lo llevó a estudiar un tema hasta entonces poco investigado científicamente: la expresión de las emociones humanas.

El naturalista inglés clasificó primero en sus hijos y luego en los amigos a los que invitaba a comer reacciones emocionales como la alegría, el asco, la ira, el miedo, la sorpresa y la tristeza. Darwin buscaba determinar si los humanos tenemos un conjunto innato y universal de expresiones emocionales, un código por el cual entendemos los sentimientos de los demás.

La evidencia científica indica que las expresiones faciales no son ni universales ni innatas. Su estudio es crucial para el éxito o fracaso de la naciente industria de la detección automática de las emociones.

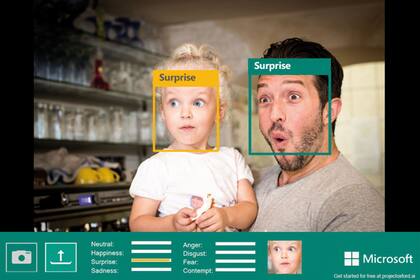

Curiosamente, estas investigaciones tuvieron poco impacto académico hasta mediados de los 70, cuando fueron resucitadas por psicólogos como Paul Ekman –cuyo trabajo inspiró la serie Lie to me– y ahora vuelven a estar en boga impulsadas por un experimento masivo de vigilancia y control: gobiernos y empresas como Amazon, Microsoft e IBM están gastando millones de dólares en sistemas de reconocimiento de expresiones faciales para detectar emociones y así determinar la satisfacción del cliente, o para contratar o no a una persona solo a partir del análisis de las expresiones faciales por parte de una computadora.

El rostro humano es la puerta de entrada en nuestras interacciones con los demás. Tras millones de años, nos hemos adaptado para identificar en microsegundos una expresión. En el siglo XXI, sin embargo, nuestras caras se han vuelto territorios de disputas: materia prima para la vigilancia y el control estatal o corporativo, al mismo tiempo que son el potencial blanco de gotas cargadas con coronavirus y puerta de entrada de la enfermedad.

Comúnmente, una sonrisa la interpretamos como alegría, el llanto lo decodificamos sin pensar como tristeza, sin importar la edad, sexo, nacionalidad y cultura de los demás. Esta suposición influye en prácticas educativas, en debates y decisiones políticas, en juicios legales. Impregna las interacciones sociales cotidianas y guía el desarrollo de aplicaciones comerciales.

Pero la evidencia científica sugiere otra cosa: las expresiones faciales no serían tan universales y directas como pensamos. La psicóloga Lisa Feldman Barrett ha estudiado científicamente las emociones los últimos 25 años. En su laboratorio de la Northeastern University en Boston ha analizado miles de rostros midiendo las señales eléctricas que contraen los músculos del rostro y producen los gestos. "Los movimientos físicos no tienen un significado emocional intrínseco", dice. "Las emociones no son expresadas ni reconocidas universalmente. Descubrimos que los adultos en culturas urbanas fruncen el ceño cuando están enojados solo el 30% del tiempo. También lo hacen cuando se concentran, cuando alguien les dice un chiste malo, fruncen el ceño por muchas razones. Esto quiere decir que fruncir el ceño no es la expresión facial unívoca de la ira".

Lo mismo ocurre con la sonrisa. "Es el prototipo de alguien que se siente feliz –indica Seth D. Pollak de la Universidad de Wisconsin–, pero a veces sonreímos cuando estamos nerviosos. La forma en que las personas comunican lo que sienten varía según las culturas y las situaciones".

La forma en que las personas comunican lo que sienten varía según las culturas y las situaciones.

Hay también diferencias de género. Las mujeres, explica Feldman, mueven más el rostro que los hombres: "Además, no leemos las emociones de los demás. Nuestros cerebros las infieren y esos juicios están mediados por la cultura".

Esta ambigüedad en nuestras expresiones –exacerbada por los 17 millones de configuraciones posibles de nuestros 42 músculos faciales– desestima cualquier afirmación contundente de que los algoritmos bien entrenados pueden detectar cuando una persona está triste o contenta con solo procesar una foto o video. "Los sistemas automáticos fallan porque se basan en una hipótesis defectuosa y peligrosa", asegura el español Aleix Martínez, ingeniero de la Universidad de Ohio. "La tecnología nunca podrá detectar así nuestras emociones".

La detección de emociones hoy es una industria de US$20.000 millones. Y se estima que en los próximos años será omnipresente y estará integrada en todos nuestros dispositivos. "Estos sistemas toman por su cuenta cada vez más decisiones importantes para nuestras vidas –advierte Martínez–. Es hora de denunciarlos".