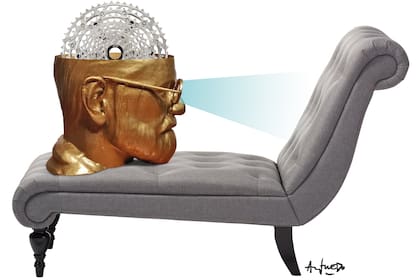

Cuando el terapeuta es un robot

Para muchos, el diván fue reemplazado por una app; lo sorprendente no es solo que la máquina responde rápido, sino que los usuarios comienzan a sentir que “hablan” con alguien que los comprende y puede ayudarlos a gestionar sus emociones

6 minutos de lectura'

6 minutos de lectura'

Actualmente presenciamos una escena que se repite con solución de continuidad: muchos de nosotros, en vez de acomodarnos en el diván o sentarnos frente a un terapeuta humano, abrimos una app, escribimos un par de frases entrecortadas y esperamos que un sistema de inteligencia artificial generativa (IAG) conteste con una mezcla de empatía sintética y razonamiento estadístico.

Lo sorprendente no es solo que la máquina responde rápido, sino que muchos usuarios de sistemas de IAG comienzan a sentir que “hablan” con alguien que los comprende, contiene y puede ayudarlos a gestionar altos niveles de ansiedad y depresión.

El fenómeno ya dejó de ser extravagancia tecnológica para convertirse en una práctica silenciosa, cotidiana y aparentemente tan efectiva como la terapia tradicional. Y es entonces cuando aparece una pregunta incómoda que atraviesa a psicólogos, tecnólogos, abogados y a cualquiera que haya llorado alguna vez en un consultorio: ¿podemos realmente hacer terapia con un robot?

Freud, que desconfiaba incluso del poder de la palabra escrita frente a la espontaneidad del discurso analítico, probablemente habría fruncido el ceño ante este interrogante o directamente habría vuelto a su tumba. El padre del psicoanálisis sostenía que “donde ello era, yo debo advenir”, para significar, en criollo y brevemente, que el proceso terapéutico supone llevar luz al territorio dominado por lo inconsciente, es decir, transformar lo que es puro impulso, pura angustia o pura repetición en algo que pueda ser simbolizado, pensado y asumido, y que dicho proceso supone la existencia de otro humano que funcione como espejo, intérprete y contenedor. Un sistema de IA estaría alejado de dicho concepto, por ahora…

Pero Freud también fue un provocador profesional y no es difícil imaginarlo hojeando con curiosidad un sistema de IA que promete descifrar nuestras angustias a partir de patrones lingüísticos. El interrogante no es menor: ¿no podría funcionar la IA como un espejo contenedor que no se cansa, no tiene familia ni obligaciones y está disponible a las tres de la mañana?

En algunas charlas con psicólogos –que trabajan en consultorios reales, con pacientes reales y angustias que no entran en un prompt–, la reacción suele ser la misma: una mezcla de fascinación y preocupación, para concluir que la escucha humana no es un algoritmo, sino un cuerpo presente, un silencio oportuno y una mirada que contiene. A todo este nuevo universo de diván digital se suma un problema menos visible, pero igual de inquietante: la posibilidad de que el “terapeuta artificial” responda de manera sesgada.

En efecto, los sistemas de IA aprenden de enormes volúmenes de texto producidos por humanos, con todos sus prejuicios incluidos. Esto puede traducirse en respuestas que refuercen estereotipos, malinterpreten situaciones sensibles o que, frente a emociones complejas, respondan con frases de autoayuda genérica, como si la angustia humana pudiera resolverse con motivación preformateada. Ese sesgo invisible es quizás el riesgo más subestimado, porque no es evidente para quien busca ayuda y confía en que el terapeuta digital sabe lo que dice.

Los defensores de la “terapia asistida por IA” señalan ventajas innegables: disponibilidad permanente, ausencia de prejuicios humanos, costo marginal casi nulo, privacidad pragmática para quienes temen exponerse ante un profesional. Aunque también reconocen otros riesgos, que no son menores, como la ilusión de comprensión: la máquina no entiende en sentido humano, solo responde con precisión estadística; puede ofrecer contención verbal, pero no puede captar el temblor en la voz ni la contradicción corporal.

Otro riesgo evidente es la dependencia: si una persona vulnerable se apega a un sistema que no puede detectar señales críticas –ideación suicida, violencia doméstica, patologías graves–, la brecha entre lo que necesita y lo que recibe puede convertirse en daño real.

Y es aquí donde aparecen algunos interrogantes en el orden jurídico: ¿quién es responsable si un chatbot da un consejo inadecuado? ¿Puede considerarse una forma de prestación sanitaria? El derecho todavía está corriendo detrás de este fenómeno, tratando de entender si hace falta regular o simplemente aceptar que el mundo cambió más rápido que los códigos. Aunque, aplicando los preceptos básicos del derecho civil, debe responder por eventuales daños causados a la salud mental de las personas, el dueño (desarrollador) del sistema de IAG, aplicando los principios de la responsabilidad civil objetiva de nuestra ley de fondo.

Mientras tanto, la sociedad se acomoda como puede. En Buenos Aires, Nueva York o San Pablo ya no sorprende escuchar a alguien manifestar que “habla de su crisis emocional con el chatbot”, con la misma naturalidad con la que antes se mencionaba al terapeuta del martes a las cinco de la tarde.

A todo este cambalache de entuertos psicodigitales se agrega que la frontera entre lo humano y lo artificial, al menos en materia emocional, se ha vuelto más porosa. Y eso inquieta. ¿Qué sucede con el secreto profesional, con la transferencia, con la construcción de confianza? ¿Qué efectos se dan cuando un bot empieza a conocer más de nuestras inseguridades que nuestra propia familia? La privacidad –ese viejo territorio en disputa– se juega en este punto un partido decisivo. No solo está en riesgo la confidencialidad, sino también la integridad emocional de quienes depositan su angustia en un sistema que aprende, acumula y procesa cada palabra.

Llegados a este punto, cabría preguntarse si estamos frente a un reemplazo o frente a una expansión del universo terapéutico. Tal vez la máquina no vino a ocupar el lugar del terapeuta, sino a llenar los huecos que la vida moderna deja abiertos: la falta de tiempo, la urgencia emocional, la soledad episódica, la necesidad de una respuesta inmediata. En ese marco, la IA podría funcionar como una especie de bastón digital. Tan útil como limitado. Tan accesible como incompleto

La conclusión, quizás, sea menos dramática de lo que parece. La pregunta no es si un robot puede ser nuestro terapeuta, sino qué esperamos nosotros de ese vínculo. Porque la terapia, incluso en su forma más clásica, nunca fue una cuestión de respuestas perfectas, sino de acompañamiento imperfecto.

La tecnología no vino a reemplazar lo humano, sino a recordarnos que lo humano es algo que todavía estamos aprendiendo a entender. Y lo humano, cuando de nuestra cabeza se trata, como de otras tantas cuestiones, nunca será reemplazable (o no debería serlo) por un sistema de IA.

Abogado y consultor en Derecho Digital y Data Privacy. Profesor de la Facultad de Derecho UBA y Austral. Autor de distintas obras de su especialidad