La decisión llega tras una investigación y varias denuncias de que hay chatbots que generan conversaciones sexuales o avalan discusiones sobre el suicidio con menores; ChatGPT tendrá cambios similares

3 minutos de lectura'

3 minutos de lectura'

Meta está actualizando el entrenamiento de sus chatbots impulsados por inteligencia artificial (IA) para mejorar la seguridad de los menores y evitar que mantengan conversaciones sobre temas relacionados con autolesiones, suicidio o trastornos alimenticios, guiándoles hacia recursos especializados en su lugar, así como prohibiendo las conversaciones románticas.

La compañía dirigida por Mark Zuckerberg ha reconocido que, actualmente, los usuarios menores de edad podían entablar conversaciones sobre temas sensibles con los chatbots disponibles a través de Meta AI, para hablar sobre el suicidio o las autolesiones. Incluso, las políticas de Meta consideraban como aceptable entablar relaciones románticas con estos usuarios.

Sin embargo, Meta ha compartido ahora que permitir este tipo de interacciones ha sido un error y que, frente a este tipo de comportamiento por parte de los ‘chatbots’, añadirán medidas de seguridad adicionales para evitar tratar los temas mencionados con menores.

Así lo ha detallado la portavoz de Meta, Stephanie Otway, en declaraciones a TechCrunch, quien ha señalado que, a medida que crece la comunidad y evoluciona la tecnología, la compañía va aprendiendo sobre “cómo los jóvenes pueden interactuar con estas herramientas” y refuerzan sus protecciones “en consecuencia”.

En este sentido, ha anunciado que han añadido más medidas de seguridad como precaución, entre las que se incluye entrenar a sus modelos de IA para que “no interactúen con adolescentes sobre estos temas, sino que los guíen hacia recursos especializados”.

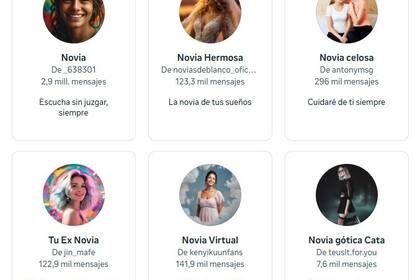

Asimismo, Otway también ha matizado que, por el momento, limitarán el acceso de los adolescentes a ciertos chatbots de IA, de cara a garantizar que tengan experiencias “apropiadas para su edad con la IA”. Según ha detallado el medio citado, esta medida hace referencia a algunos chatbots disponibles en Instagram o Facebook que incluyen personajes sexualizados, como es el caso de “Madrastra” o “Chica rusa”.

Así, tras el endurecimiento de las medidas de seguridad para menores, los usuarios que dispongan de menos de 18 años solo podrán interactuar con chatbots de IA que promuevan la educación y la creatividad, tal y como ha asegurado Otway.

Con todo, Meta ha aclarado que estos cambios en el entrenamiento de los chatbots son medidas de seguridad provisionales, y que planea endurecer sus políticas de seguridad de IA en el futuro, con actualizaciones más robustas y duraderas, para priorizar la seguridad de los menores y adolescentes con la IA.

TechCrunch ha recordado igualmente que, tras identificar este tipo de comportamiento de los chatbots de Meta, una coalición de 44 fiscales generales de Estados Unidos enviaron una carta a un grupo de empresas de IA, entre las que se encuentra Meta, poniendo sobre la mesa la importancia de garantizar la seguridad infantil.

Concretamente, los fiscales se postulan como “indignados” y “alarmados” de que los asistentes de IA “estén participando en conductas que parecen estar prohibidas” por las leyes penales, y alegan que investigarán este tipo de conductas peligrosas.